🕔: 7 min – Technik: ✔

Generative versus Analytische künstliche Intelligenz

Künstliche Intelligenz ist ein faszinierendes, breites Feld, das von analytischer KI, die verborgene Muster in Daten erkennt, bis hin zu generativer KI reicht, die eigenständig völlig neue Inhalte wie Texte oder Bilder erschafft. Diese beiden Kategorien sind die tragenden Säulen der modernen KI-Welt. Während analytische KI uns unsichtbar im Alltag begleitet – etwa in Sprachassistenten oder personalisierten Empfehlungen – ist generative KI das Herzstück kreativer Innovation: Sie nimmt Chaos, Zufallsmuster und formt daraus etwas völlig Neues. In den folgenden Abschnitten nehmen wir dich mit auf eine klare Reise: Wir zeigen Schritt für Schritt, wie generative KI am Beispiel von Bildgenerierung funktioniert. Dieses eine Beispiel hilft uns, die grundlegenden Prinzipien zu verstehen, denn dieselben Mechanismen stecken auch hinter Text- oder Musikgenerierung. So erhältst du einen tiefen Einblick in die Mechanik, mit der diese Technologien unsere Kreativität neu definieren – und dabei gleichzeitig neue Fragen und Herausforderungen mit sich bringen.

Beispiele einer generativen KI

Künstliche Intelligenz findet in vielen Bereichen Anwendung. Privat nutzen wir sie oft für Texte, etwa mit ChatGPT, für Bilder, wie DALL-E oder Stable Diffusion, und auch Musik, zum Beispiel mit Jukebox. Industriell wird KI eingesetzt für Code-Generierung, wie bei Claude, oder zur Erstellung von 3D-Objekten, etwa mit Hunuan 3D. Trotz dieser Vielfalt nutzen all diese Anwendungen dieselben Grundelemente: einen präzisen Prompt, eine Vektordatenbank zur Speicherung relevanter Muster und ein KI-Modell, das diese Muster interpretiert und neue Inhalte generiert.

In den folgenden Abschnitten werden wir diese Bausteine genauer erkunden, um ein grundlegendes Verständnis zu vermitteln, ohne in technische Tiefen abzuschweifen. Dies tun wir exemplarisch am Beispiel der Bildgenerierung mit einem Diffusionsmodell. Andere Modelle mögen abweichen, doch dieses Beispiel gibt uns ein solides Fundament. So vermitteln wir ein klares Grundverständnis, ohne uns in technische Details zu verlieren.

Schritt 1: Vorbereitung

Zuerst erstellen wir ein KI-Modell oder nutzen ein bereits vortrainiertes Basis-Modell, das aus einer großen Menge allgemeiner Daten gelernt hat wie zum Beispiel typische Objekte und Szenen. Doch wie bei einem Menschen sind diese Modelle begrenzt: Sie können nur das gut generieren, was sie schon gesehen haben. Spezifische oder seltene Objekte fallen daher manchmal durchs Raster. In unserem einfachen Beispiel setzen wir jedoch auf das Standardmodell, um es überschaubar zu halten. Wir könnten zwar auch ein spezielles Training durchführen, bei dem das Modell anhand vieler Beispieldaten nach und nach besser wird, aber für unser Ziel reicht es, diesen Lernprozess nur kurz zu erwähnen, um zu verstehen, wie wir Modelle anpassen.

Schritt 2: Anlernen und Trainieren.

Stell dir vor, du gibst einem Kind ein leeres Blatt und sagst: „Mal einen Baum.“ Zuerst kritzelt es wild, doch mit jedem Versuch und durch Vergleiche lernt es, genauer zu zeichnen. Genauso trainiert unser Modell: Es startet mit Zufallsrauschen (dem sogenannten Seed), generiert daraus ein Bild und vergleicht es mit echten Beispielen. Über viele Durchläufe, oft Tausende, passt es seine Einstellungen an, bis es die feinen Muster erkennt.

Meist handelt es sich dabei nicht um ein komplett eigenständiges Modell, sondern um eine Anpassung eines bestehenden Modells, wie etwa eine LoRA (Low-Rank Adaptation). Diese Anpassung verändert gezielt bestimmte Teile des Modells, sodass es neue Stile, Objekte oder Details lernen kann, ohne das gesamte Modell neu zu trainieren. Am Ende entsteht so ein Bild, das genau dem entspricht, was wir ursprünglich vorgegeben haben.

Schritt 3: Der Schlüssel liegt im Prompt (Prompt Engineering)

In diesem Schritt definierst du über den Prompt, was das Modell erzeugen soll. Der Prompt ist die inhaltliche Vorgabe und beschreibt möglichst klar Motive, Eigenschaften, Stilrichtungen, Perspektiven, Details oder gewünschte Stimmungen. Je präziser und strukturierter die Beschreibung, desto gezielter kann das Modell arbeiten und desto kontrollierbarer wird das Ergebnis.

Unterschiedliche Modelle interpretieren Prompts unterschiedlich. Manche reagieren stärker auf Stilbegriffe, andere auf technische Parameter oder Gewichtungen einzelner Begriffe. Deshalb gehört zum Prompt Engineering auch das Verständnis dafür, wie ein bestimmtes Modell Informationen verarbeitet und priorisiert.

Neben dem eigenen Schreiben eines Prompts besteht auch die Möglichkeit, Prompts durch andere KI-Modelle generieren oder optimieren zu lassen. Das kann helfen, strukturiertere Beschreibungen zu erstellen, alternative Formulierungen zu finden oder komplexe Ideen in maschinenlesbare Anweisungen zu übersetzen.

Gutes Prompt Engineering ist oft entscheidend für die Qualität des Ergebnisses. Kleine Anpassungen in Formulierung, Reihenfolge oder Detailgrad können große Unterschiede im finalen Bild erzeugen. Mit zunehmender Erfahrung entwickelt man ein Gefühl dafür, welche Informationen notwendig sind und wie stark man das Modell steuern oder bewusst Freiraum lassen sollte.

Schritt 4: Lass die Magie beginnen – was im Hintergrund passiert

Mit diesem Schritt ist für dich als Nutzer eigentlich schon alles vorbereitet – der Prompt steht fest und die Generierung kann starten. Während du auf das Ergebnis wartest, läuft im Hintergrund jedoch eine ganze Kette an Prozessen ab, die aus deiner Beschreibung Schritt für Schritt ein Bild entstehen lassen.

Zuerst muss das System deinen Prompt überhaupt „verstehen“. Computer können mit normaler Sprache nichts anfangen, daher wird deine Texteingabe zunächst in Zahlen umgewandelt – sogenannte Vektoren. Diese enthalten die Bedeutung deiner Worte in einer Form, mit der das Modell arbeiten kann. In unserem Workflow übernimmt diese Aufgabe der sogenannte CLIP-Textencoder (bzw. je nach Modell auch mehrere Encoder). Wichtig ist dabei: Unterschiedliche Modelle nutzen unterschiedliche CLIP-Varianten, da sie genau mit diesen während des Trainings gelernt haben.

Schritt 5: Das Modell – Seed und Vektorverarbeitung

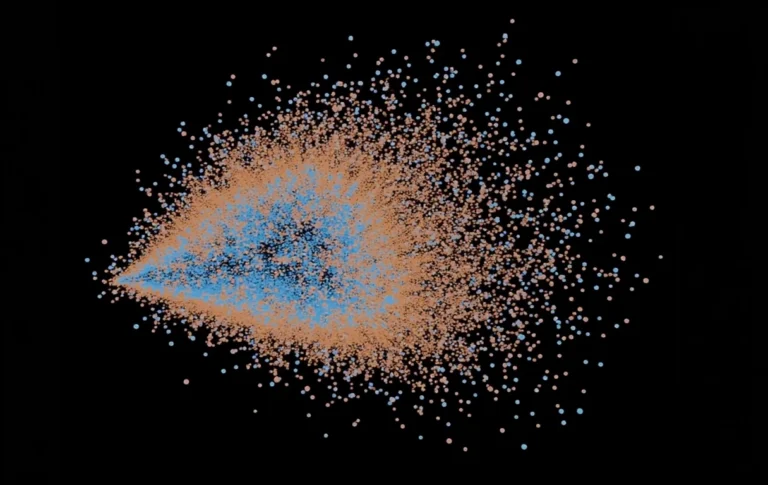

Jetzt, wo der Prompt fertiggestellt ist, startet das eigentliche Modell mit der Generierung. Alles beginnt mit dem sogenannten Seed, einem zufälligen Rauschmuster, das den Ausgangspunkt für das Bild bildet. Man kann sich das vorstellen wie eine leere Leinwand, die zunächst nur aus wirren Pixeln besteht – ein chaotisches Durcheinander ohne erkennbare Strukturen.

Gleichzeitig verarbeitet das Modell die Informationen aus deinem Prompt, die zuvor in Vektoren übersetzt wurden. Diese Vektoren enthalten die Bedeutung deines Textes in einer Form, die das Modell interpretieren kann, und dienen als Leitfaden für den Aufbau des Bildes. Während der Generierung entsteht so eine Art „kreativer Dialog“ zwischen dem Seed und den Vektoren. Das Modell interpretiert, kombiniert und verfeinert die latente Repräsentation des Bildes Schritt für Schritt.

Wichtig ist: Am Ende dieses Vorgangs liegt das Bild noch im latenten Raum vor – es ist also noch nicht als sichtbares Bild ausgegeben. Alle Formen, Strukturen und Details existieren intern als abstrakte mathematische Repräsentation. Erst im nächsten Schritt wird diese latente Darstellung in ein normales, sichtbares Bild umgewandelt, das wir anschließend betrachten können.

Durch diesen Prozess formt das Modell aus reinem Rauschen eine strukturierte Darstellung, die genau zu den Informationen deines Prompts passt.

Schritt 6: Vom latenten Raum zum fertigen Bild

Nachdem das Modell im vorherigen Schritt das Bild vollständig im latenten Raum aufgebaut hat, geht es nun darum, diese interne Darstellung in ein sichtbares Bild zu überführen. Der latente Raum ist eine abstrakte, mathematische Form des Bildes – das Modell arbeitet hier sehr effizient, speichert Muster und Strukturen, aber wir könnten es noch nicht ansehen.

Um daraus ein normales Bild zu erzeugen, wird ein Variational Autoencoder (VAE) eingesetzt. Dieser übernimmt die Aufgabe, die latente Repräsentation in Pixelwerte zu dekodieren. Man kann sich das vorstellen wie das Übersetzen einer abstrakten Skizze in ein echtes Bild: Farben, Formen und Details werden sichtbar, während die interne Struktur des Modells erhalten bleibt.

Das Modell hat bereits Schritt für Schritt alle Details geformt: Konturen, Muster, Texturen und Komposition stimmen nun mit dem Prompt überein. Der VAE übersetzt diese Informationen in ein finales Bild, das wir sehen und weiterverwenden können.

Am Ende dieses Prozesses hältst du das fertige Bild in der Hand – das Ergebnis eines koordinierten Zusammenspiels von Seed, Vektoren, Diffusionsprozess und latenter Repräsentation. So entsteht aus einer abstrakten Zahlenwolke ein sichtbares, stimmiges Bild, das genau den Vorgaben deines Prompts entspricht.

Fun Fact: Kreativität

Wenn man denselben Prompt, dasselbe Modell und denselben Seed verwendet, erzeugt ein KI-Bildgenerator immer exakt dasselbe Bild. Die „Kreativität“ der KI entsteht dabei fast ausschließlich durch das anfängliche zufällige Grundrauschen – und anders als beim Menschen ist dieses kreative Ergebnis vollständig reproduzierbar. Mit anderen Worten: eine KI kann die gleiche Idee immer wieder exakt wiederholen, während menschliche Kreativität von Natur aus variabel und unvorhersehbar ist.

Fun Fact: Auch Modellen kann beim Trainieren der Kopf rauchen

Ein KI-Modell kann so stark trainiert werden, dass es die Trainingsdaten perfekt auswendig kennt – und dabei völlig vergisst, wie es auf neue, unbekannte Daten reagieren soll. Dieses Phänomen nennt man Übertrainieren (Overfitting). Anders als beim Menschen, der beim Lernen oft generalisiert, merkt die KI sich jedes Detail bis ins kleinste Pixel. Das führt dazu, dass die erzeugten Ergebnisse manchmal übertrieben, seltsam oder geradezu komisch wirken – ein bisschen so, als würde die KI „zu schlau für die Übung“ sein.

Und so funktioniert generative KI – fast immer nach demselben Prinzip

Egal, ob es Bilder, Texte oder Musik erzeugt – die meisten generativen KI-Modelle arbeiten nach ähnlichen Grundprinzipien: Sie wandeln große Mengen an Trainingsdaten in Vektoren im latenten Raum um, erkennen Muster und lernen, wie diese Muster sinnvoll kombiniert werden können. Das Modell startet mit etwas Zufall (dem Seed), „probiert aus“ und passt seine internen Einstellungen an, bis es ein Ergebnis erzeugt, das den Vorgaben entspricht.

Obwohl die Architekturen oder Datenarten unterschiedlich sind, bleibt die Kernidee immer gleich: Lernen von Beispielen, Navigieren im latenten Raum und schließlich das Generieren von etwas Neuem, das auf diesen gelernten Mustern basiert.

Wir hoffen, dass wir euch mit diesem Beispiel die Welt der künstlichen Intelligenz etwas verständlicher machen konnten und freuen uns wie immer auf euer Feedback.